FCAS AG Technikverantwortung Protokoll der Sitzung

28. Oktober 2022 Berlin

Programm Update

Status Update aus programmatischer, technologischer und politischer Perspektive. Hervorhebung der Bedeutung von KI für ein Programm wie FCAS. Aktuell befindet sich das Programm in der Phase der Technologie-Reifmachung. Seit der letzten Sitzung hat sich die geostrategische Situation grundlegend gewandelt, mit dem russischen Angriff auf die Ukraine. Auch das wird Auswirkungen auf ein FCAS haben, wenngleich die Details hierzu noch zu definieren sein werden. Auch die Bedeutung der deutsch-französischen Kooperation wurde durch den Krieg nochmals unterstrichen.

Zur technischen Übertragbarkeit der Regeln des humanitären Völkerrechts in KI

Abgrenzung Autonome Systeme vs. Systems of Systems vs. General AI. KI-Anwendung im militärischen Kontext: Eine konkrete Handlung z.B. Objekterkennung, worauf hier der Fokus liegt. Politisches Frage: Soll die KI ein rechtskonformes Ergebnis liefern? Muss die KI eine Regel verstehen? Oder reicht Umsetzung, die regelkonform ist? D.h., Rechtskonformität (ob) vs. Rechtskonformes Verhalten (wie). Politisch und ethisch zu definieren: Welche Entscheidung darf eine KI überhaupt treffen?

Fragen:

Wie kann man in der Zweifelsregel sinnvoll an den Menschen übergeben?

Wie konkret muss ein Katalog definiert werden? Zumal mehr Definition auch die Flexibilität einschränkt? Wird das pro Einsatz definiert, oder allgemein und grundsätzlich?

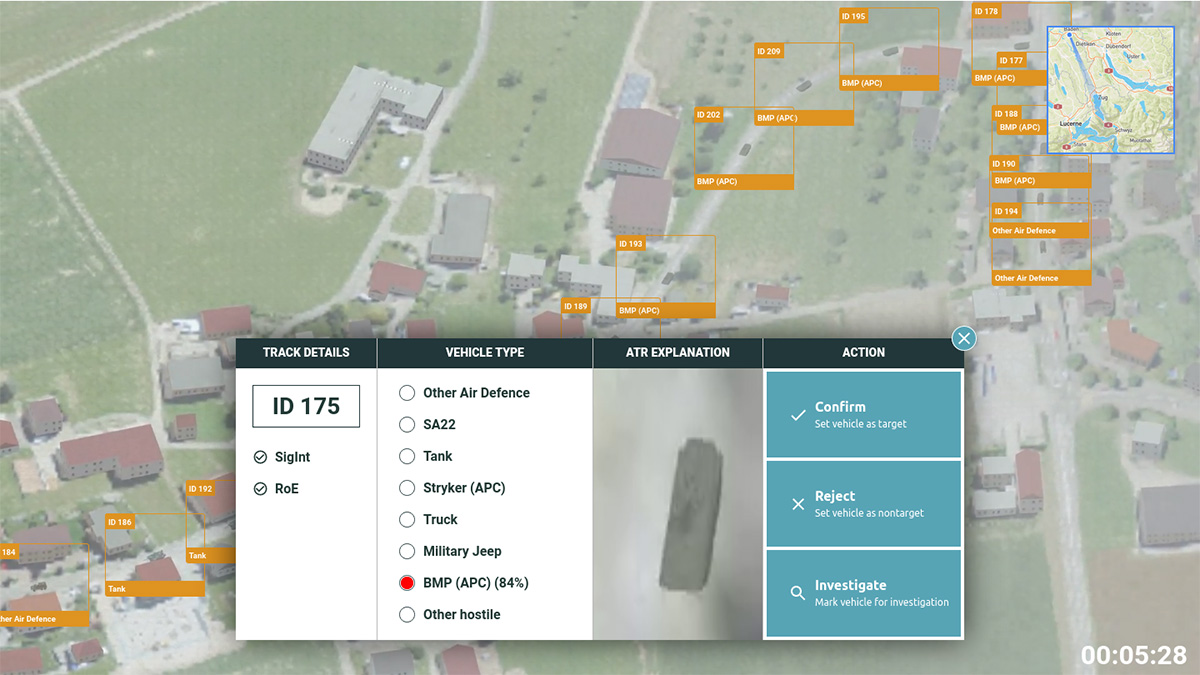

Konkreter Anwendungsfall: Objekterkennung von Gefechtsfahrzeugen, Anwendung in Führungssystem integriert, sehr kleiner Teil vom Targeting ist entscheidungsunterstützt.

Man braucht einen Grundstock an Daten: Welche Nation verfügt über welche Waffensysteme?

Es müssen Schnittstellen geschaffen werden, um Multi-Domain-fähig zu sein. Daten müssen zum richtigen Zeitpunkt am richtigen Ort sein und nicht, um die Welt reisen. Welche technischen Herausforderungen müssen gemeistert werden? Wenn KI „überall“ ist, ist das möglicherweise zu komplex. Was passiert bei einem Ausfall der Kommunikation? Ziele so frühzeitig wie möglich definieren; juristische und operative Elemente müssen in Einklang gebracht werden. Wo sitzen die Entscheider?

Das Patriot-System hat seit 30 Jahren Automatisierung, die keine nennenswerten Fragen aufwirft; kritische Funktionen werden von Menschen übernommen. Für FCAS: Was soll der Mensch übernehmen? Wo braucht man seine Kontrolle? Welche Rolle spielt der Mensch? Hängt stark vom Operationskontext ab: je nach Kontext kann die Maschine mehr oder weniger übernehmen. Was sind die Leitplanken, in der die Maschine operieren soll? Update zur Demonstrator-Entwicklung

Ethische Aspekte von KI im militärischen Einsatzszenario erfahrbar machen: Update zur Demonstrator-Entwicklung

Vorstellung des Status Quo KI-Demonstrator (ethical AI in a FCAS).

KI liefert viele und meist auch sehr gute Informationen und Daten, aber sie müssen für den Menschen aufbereitet werden. ATR kann z.B. durch kluge Verdeckung von Fahrzeugen getäuscht werden (Tarnung)

Erklärung des Szenarios.

Vergleich mit Entscheidungen in der Medizin: Stichwort Triage, Hier werden Entscheidungen über Leben und Tod (mit KI) getroffen und sind rechtlich abgedeckt.

IEEE 7000 Standard:

Sieben Säulen künstlich intelligenter Systeme: Hauptsäule in FCAS “Anthropocentrism“.

Wie kann man Ethik operationalisieren? Dabei kommen verschiedene Wissenschaftsbereiche ins Spiel: Mathematik, Physik, Ingenieurswissenschaften & Psychologie, Kognitions- und Arbeitswissenschaft: für FCAS müssen Systemtechnische Forschungsfragen gestellt werden!

Verantwortung steht im Fokus.

IEEE Standard Model Process for Adressing Ethical Concerns during System Design: Zivile und kommerzielle Initiativen for AI Complicance.

IEEEE 7000-2021 eine Serie von Standards, viele betreffen FCAS nicht, aber vielleicht gibt es IEEE-700x, der uns betrifft und den wir mitprägen können.

Mensch bleibt im Zentrum und wird immer der Entscheider bleiben; Operateur will maximal entlastet sein: Vertrauen, dass Software funktioniert und zertifiziert ist. Ein FCAS-System muss derlei Kernwerte widerspiegeln. Standard allerdings evtl. nicht vollumfänglich anwendbar, weswegen die Umsetzung in den Prozess integriert werden sollte. Man sollte Modellierung machen und Umsetzungsmaßnahmen treffen. Sollte es zu unvorhersehbaren Ereignissen kommen, ermöglicht Dokumentation eine Analyse;

Way-ahead

Mit bestehenden Patriot MMI Systemen beschäftigen, die etabliert sind. Frage der Doktrin: Bedarf eine Festschreibung von KI Anwendung in Waffensystemen; idealerweise abgestimmt mit den internationalen Partnern. Unbemannte Systeme können bewaffnet werden; es wurde definiert, dass der Mensch im Mittelpunkt steht, aber es wurde nicht geklärt, wann solche Systeme eingesetzt werden können. Durchführung eines Workshops zur Schärfung des Ethik-Begriffs im Kontext FCAS (13. Januar 2023).